ChatGPT似乎无处不在,但指令调整文本生成器的开源版本正在占据上风。在六个月内出现了至少15个替代方案,这些替代方案相比ChatGPT有一个重要优势:它们更加透明。拉德堡德大学的语言学家和语言技术研究人员团队声称,深入了解训练数据和算法是负责任地使用生成式人工智能的关键。对于任何想要更好地理解此类模型或在其上构建应用程序的人来说,这都是一种责任。

研究人员在论文“Opening up ChatGPT: Tracking openness, transparency, and accountability in instruction-tuned text generators”和一个实时更新的网站中描绘了这一快速发展的格局。 这表明有许多可用的替代“开源”文本生成器,也有一定程度的开放性,并且许多模型继承了法律限制。

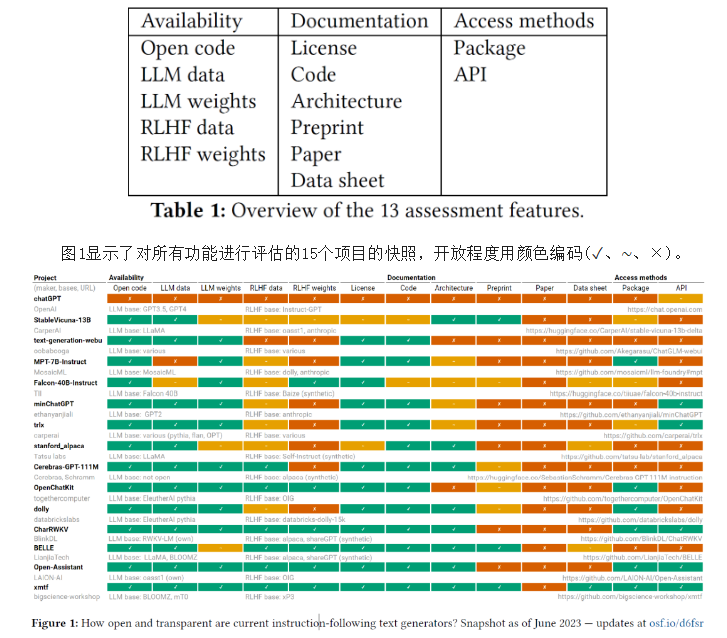

研究采用了13个指标(表1)对大语言模型的开放度和透明度进行了评估。包括三个部分:可用性、文档、访问方法。对于每个功能,按照从最大到部分到不开放和透明的范围记录开放性。对于许可证而言,只有真正的开源许可证完全覆盖的系统才算作最大开放,不太宽松或部分许可的系统才算作部分开放,非开放或不明确的许可情况才算作封闭。

项目大致分为两类。首先,小型、相对简单的项目,仅提供源代码并基于现有的大型语言模型构建。这些项目通常无法共享有关架构、培训数据和文档的信息,因为它们从其构建的大语言模型继承了闭源数据。他们通常也不提供API或其他用户界面。然而,其中一些小型项目确实附带了高质量的文档,有些项目仅建立在明确开放的大语言模型的基础上。这些小型项目虽然在性能上有所欠缺,但它们对开源社区的实用性有所弥补,因为它们可以为学习LLM+RLHF工具提供有用的切入点。【注:(1)LLM:大规模语言模型;(2)RLHF:以强化学习方式依据人类反馈优化语言模型】

一些项目并不像最初看起来那样开放,其中许多项目只是封闭模型的包装。在可用性和文档方面反复出现三个问题:①未记录数据的继承。许多工具建立在现有的大型语言模型(或称为基础模型)之上,并继承了这些基础模型所训练的未记录的数据集。②RLHF 组件的训练数据不共享。 构建 RLHF 训练数据集需要人类注释者进行劳动密集型工作。 缺乏 RLHF 训练数据是小型研究团队和组织的主要性能瓶颈,并且阻碍了针对对话用户界面使用指令调整文本生成器的可重复性研究。③论文很少,同行评审更是罕见。 这里审查的大多数项目都遵循企业“通过博客发布”模型。 虽然有一些预印本,但我们审查的系统目前都没有记录在同行评审的论文中。

研究表明,模型的开放程度各不相同:许多模型只共享语言模型,其他模型还提供对训练数据的见解,而且相当多的模型被广泛记录。作者说:“以目前的形式,ChatGPT不适合在研究和教学中负责任地使用。它可以反刍单词,但没有含义、作者身份或正确归属的概念。它是免费的只是意味着我们为OpenAI提供免费劳动力和访问我们的集体智慧。有了开放模型,至少我们可以深入了解技术,并做出明智的技术决策。”

开放性并不是对话文本生成器所面临的科学和伦理挑战的完整解决方案。 开放数据不会减轻轻率部署大型语言模型所带来的有害后果,也不会减轻从互联网上抓取所有公开可用数据所带来的可疑版权影响。 然而,开放性确实使原创研究成为可能,包括努力构建可重复的工作流程并了解 LLM + RLHF 架构的基础知识。开放性还可以实现制衡,培养对数据及其管理、模型及其部署负责的文化。

新闻内容来自以下网站,不代表GoOA头条立场:

https://techxplore.com/news/2023-07-alternatives-chatgpt-ai.html

https://arxiv.org/pdf/2307.05532.pdf